※ 이전 글:

- On-Prem AI 서비스-(1) dcgm-exporter 구성

- On-Prem AI 서비스-(2) prometheus + grafana 설정

- On-Prem AI 서비스-(3) Local LLM은 왜 필요할까?

- On-Prem AI 서비스-(4) Ollama

Open WebUI

ollama는 기본적으로 텍스트 기반 UI 를 제공합니다. 이전 글에서 언급했었지만 단일 주제 대화는 문제가 없지만 AI 모델 변경 과정이 불편하고 ( “대화 중단>ollama TUI 중지=>AI 모델 변경“), 과거 대화 이력 관리도 불가하며, 대화 주제별 관리가 불가능합니다. Open WebUI 는 ChatGPT, Gemini와 같은 Web UI 로서 ollama 와 함께 사용할 수 있습니다.

AD

Open WebUI 설치

Docker 이용한 설치는 무척 간단하게 할 수 있습니다. 아래는 docker-compose.yml 예제입니다.

Bash

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main # default

container_name: open_webui # (선택) 컨테이너 이름

restart: always # 재시작 정책

ports:

- "3000:8080" # 호스트 3000 포트 → 컨테이너 8080 포트

volumes:

- ./data:/app/backend/data

extra_hosts:

- "host.docker.internal:172.22.0.1" # 호스트 내부 접근용

environment:

- DOCKER=True

- OLLAMA_BASE_URL=http://host.docker.internal:11434 # Ollama

networks:

- open_webui_default

networks:

open_webui_default:

external: true

- volumes: Open WebUI에서 사용할 data 저장 공간을 docker volume 또는 임의의 폴더를 만들어서 지정

- extra_hosts: ollama 서비스와 통신이 가능한 host 정보를 docker 내부에 정의할 경우 사용.

- OLLAMA_BASE_URL: ollama 서비스 주소.

Open WebUI 접속

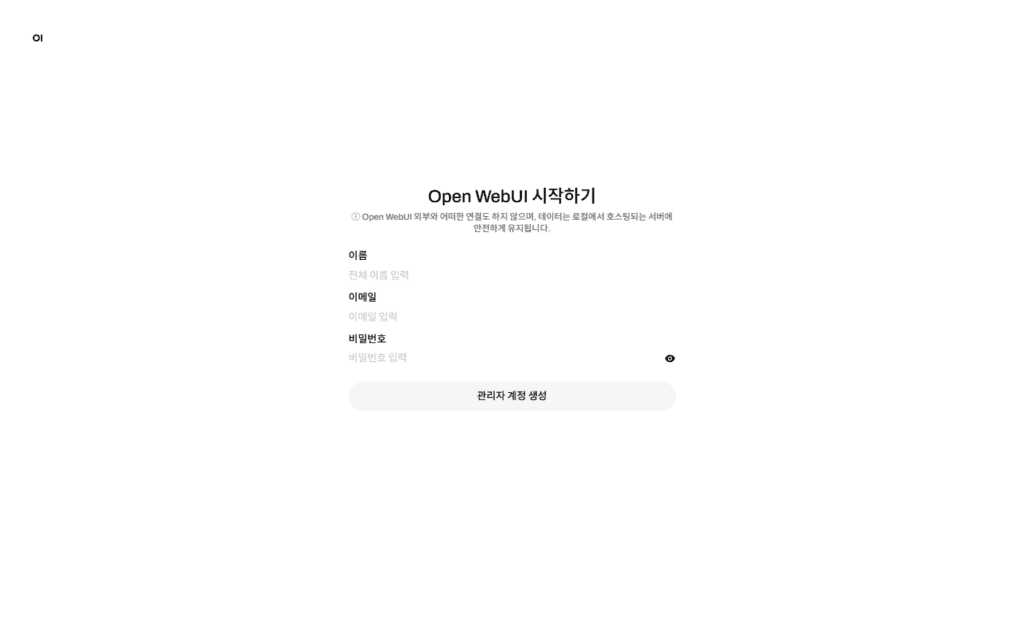

Open WebUI instance 실행이 성공하면 http://<Open WebUI IP>:3000 으로 접속 가능합니다.

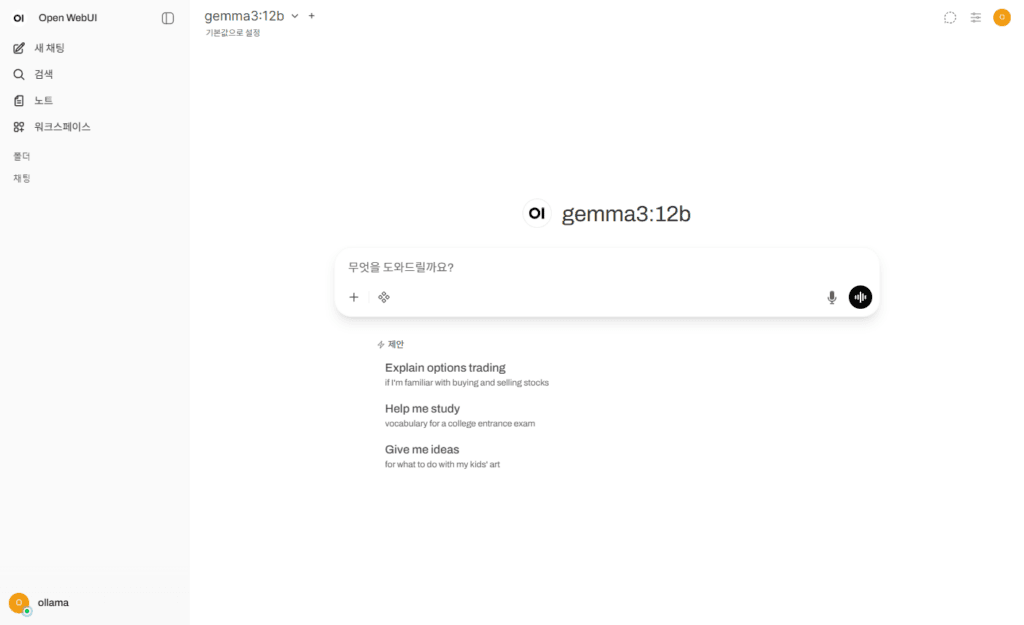

관리자 계정을 등록하면 Open WebUI 대화 화면을 볼 수 있습니다.

Open WebUI는 AI 모델 변경, 대화 이력 관리, 외부 도구와의 연계 등 다양한 기능을 제공하고 있기에 ollama TUI 보다 훨씬 편하게 Local LLM 사용 환경을 구축할 수 있습니다.

AD

![[WordPress enfold theme] Related posts styling](https://www.boolsee.pe.kr/wp-content/uploads/2018/04/enfold-100x70.png)